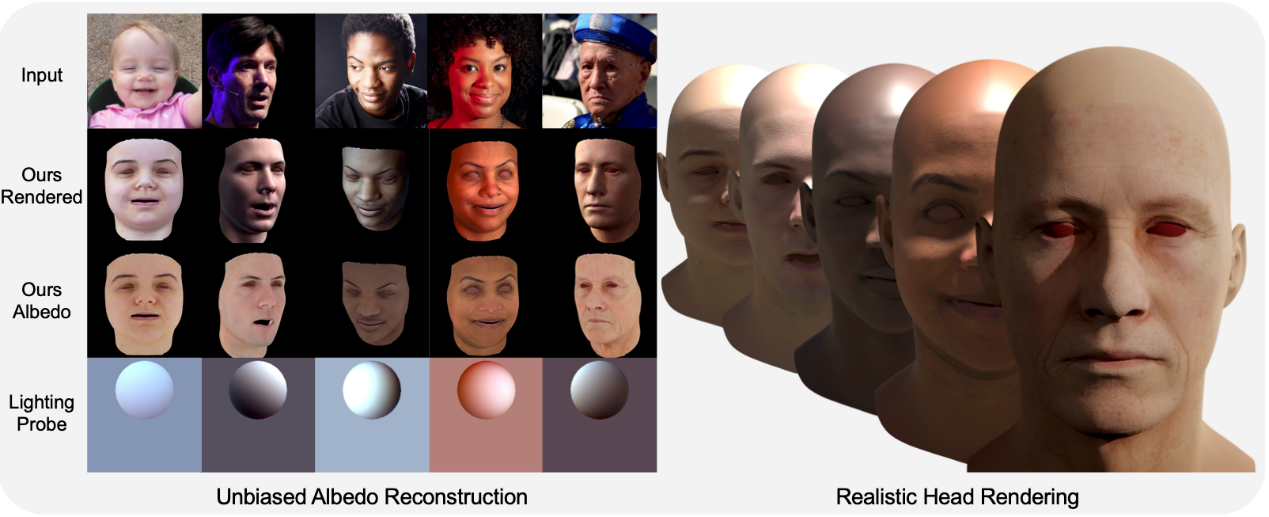

大模型驱动的人脸albedo估计算法ID2Albedo,能够从各种特异性光照的图片中,估计出目标任务本身的albedo贴图,并能够与现有的CG流程对接。

在本算法中,我们重新考虑反照率和人脸属性之间的关系,并提出了 ID2Albedo 来直接估计反照率,而无需约束照明。 我们的主要见解是,种族、肤色和年龄等内在语义属性可用于约束反照率图。 我们首先引入视觉文本线索并设计语义损失来监督面部反照率估计。 具体来说,我们预先定义种族、肤色、年龄和皱纹等文本标签。 然后,我们采用文本图像模型(CLIP)来计算文本和输入图像之间的相似度,并为每个面部图像分配一个伪标签。 我们将训练阶段生成的反照率限制为与输入具有相同的属性。 此外,我们训练了一个高质量、无偏差的面部反照率生成器,并利用语义损失来学习从光照鲁棒的身份特征到反照率潜在代码的映射。 最后,我们的 ID2Albedo 以自我监督的方式进行训练,在准确性和保真度方面优于最先进的反照率估计方法。 值得一提的是,我们的方法具有出色的通用性和公平性,尤其是在任意场景的数据上。

相关论文发表于世界顶级计算机视觉会议CVPR2023中。